Épistémologie de l’IA: quelles influences des IA de traduction dans la production scientifique ?

L’essor de la traduction et de l’interprétation automatiques fiables grâce aux intelligences artificielles (IA) est une avancée majeure (sauf pour les traducteurs dont le métier évolue et pourrait disparaître). Depuis la nuit des temps, l’incapacité de communiquer avec l’autre est source de peur et un obstacle à la fraternité humaine, surtout entre les hommes.

Aujourd’hui, nous sommes encore loin d’un multilinguisme parfait. Les IA actuelles – Google Traduction, DeepL, ChatGPT, DeepSeek, etc. – posent toujours des défis en matière de fiabilité et de capacités linguistiques. Il est donc utile d’évaluer leurs apports pour la recherche et la diffusion de travaux, tout en identifiant leurs limites et précautions d’usage.

Cette analyse repose notamment sur mon expérience de traducteur et correcteur, sur une lecture succincte de la littérature à propos de la traduction automatique, sur les retours d’expérience de l’utilisation de DeepL Pro à Paris 1 Panthéon-Sorbonne et une comparaison entre des requêtes ChatGPT-4o et DeepSeek sur « l’épistémologie de l’IA » en matière de traduction.

Des percées technologiques

La traduction automatique existe depuis longtemps et s’est développée dès les années 1950 avec des « systèmes à base de règles » linguistiques strictes. Ces modèles utilisaient des dictionnaires et des grammaires formelles, mais leur rigidité limitait leur efficacité. Dans les années 1980, l’essor de l’intelligence artificielle a permis l’émergence de la « traduction automatique statistique », qui analysait de vastes corpus bilingues pour établir des probabilités de correspondance entre les phrases.

Ce modèle a été surpassé dans les années 2010 par la traduction automatique neuronale (TAN), fondée sur des réseaux de neurones et l’apprentissage profond (deep learning). Cette approche modélise des structures de phrases entières en fonction de leur probabilité d’usage, contextualisant ainsi les mots et expressions. D’abord utilisée par la société chinoise Baidu en 2015, elle a été adoptée par Google Translate et DeepL, qui produisent aujourd’hui des traductions plus fluides et naturelles en tenant compte du contexte linguistique global.

Un atout majeur de la TAN est sa capacité d’auto-apprentissage, qui s’améliore à mesure qu’elle traduit des textes. Les réseaux neuronaux sont également à la base de ChatGPT et DeepSeek, qui peuvent aussi être utilisés pour la traduction.

Des textes différents et des traductions apparemment « bonnes »

Bien que la TAN puisse parfois rivaliser avec l’expertise humaine, elle nécessite généralement encore un travail de « post-édition » plus ou moins lourde. Celle-ci va de la correction fastidieuse de la ponctuation (souvent calquée sur la langue source) à la révision de la syntaxe et du séquençage des phrases, en passant par la vérification du sens et l’élimination des « hallucinations » de l’IA.

Par ailleurs, tous les textes ne se traduisent pas de la même manière. Certains styles, comme la littérature ou la communication spécialisée, exigent une adaptation plus fine de la traduction. En revanche, la traduction de recherches aux résultats chiffrés ou techniques s’adapte mieux à la traduction automatique. Ici, « le post-éditeur doit même partir du principe que, dans certains cas, le lecteur peut tolérer un certain niveau de ‘langage artificiel’ à partir du moment où le texte reste intelligible, exact et grammaticalement correct »1.

Toutefois, l’illusion d’une communication fluide peut piéger les personnes maîtrisant bien la langue cible sans en avoir la pleine aisance native. Malgré une correction soignée, des erreurs ou maladresses peuvent subsister2.

Des gains en temps et en argent… mais un travail de « post-édition » important

Pour les chercheuses et chercheurs et leurs laboratoires, la traduction classique est onéreuse (elle coûte environ 1 000 € pour un article de 8 000 mots). L’informatique a d’abord permis de limiter les coûts (grâce à des outils comme Trados ou Systran… qui aident à gérer des documents et qui génèrent des mémoires de mots et d’expressions utilisés). Aujourd’hui, les plateformes de TAN permettent de réaliser d’importantes économies en frais de traduction. Toutefois, une relecture soignée reste essentielle – pour le moment – sauf dans certains cas (par exemple, en cas de manque de temps, ou de diffusion restreinte de littérature grise).

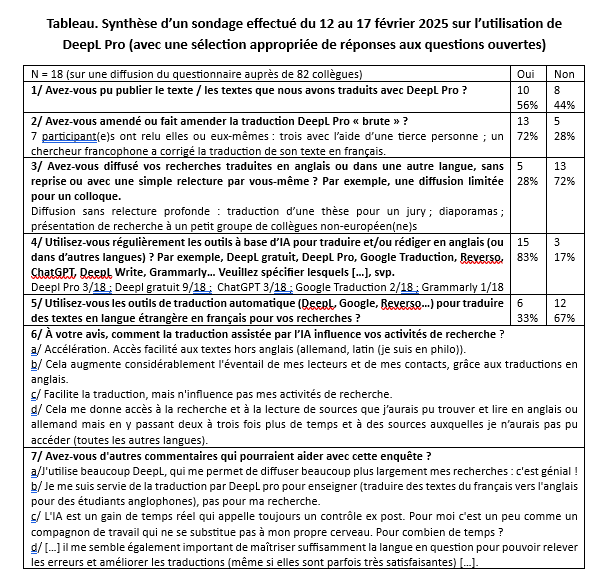

Ces contraintes ressortent d’un sondage (qualitatif) mené auprès des collègues de l’université Paris 1 Panthéon-Sorbonne qui ont utilisé DeepL Pro via l’expérience que je mène avec la Direval depuis mai 2023. Les réponses au questionnaire diffusé (en questions ouvertes et fermées) sont synthétisées dans le tableau.

Pour synthétiser, le sondage suggère que :

- le recours à DeepL Pro aide à publier en anglais (10 cas sur 18 retours) ;

- le travail de post-édition est assez généralisé, effectué principalement par les auteur(e)s, parfois avec l’aide de locatrices natives ou de locuteurs natifs ;

- la diffusion de traductions sans révision reste limitée à des cas particuliers ;

- l’utilisation de DeepL gratuit est répandue parmi les outils utilisés ;

- les IA sont surtout utilisées pour la diffusion de la recherche (pour l’instant).

L’anglais ou le « globish » comme la lingua franca de la recherche ?

Le recours limité à la traduction automatique pour la recherche reflète probablement la capacité des chercheuses et chercheurs à lire des sources dans leur langue d’origine, notamment en anglais, devenu la lingua franca académique, renforcé, qu’on le veuille ou non, par la mondialisation et par Internet ces dernières décennies. Mais l’anglais, désormais langue de communication internationale, a « échappé » à ses pays d’origine, pour devenir une langue de communication internationale avec des usages, des règles et des prononciations multiples devenus acceptables à condition que la parole soit compréhensible3. Au plus simple, on parle souvent du « globish » : « un anglais parfaitement correct, mais limité » à quelques 1 500 mots, une grammaire « allégée », une syntaxe à « phrases courtes » et une prononciation « intelligible »4.

Pour ce qui est de la langue écrite, c’est plus compliqué, car la précision de l’écrit est plus exigeante, surtout si l’on doit communiquer un raisonnement complexe et nuancé. Certes, on trouve des « formes non canoniques » (non-canonical patterns) dans des revues académiques, même de premier rang, pour des raisons de manque de moyens . Cependant, l’exigence d’une reprise soigneuse – d’une post-édition onéreuse en temps et parfois en argent – persiste si l’on souhaite soumettre un texte de qualité en termes linguistiques.

Les IA et la traduction multilingue vont-elles détrôner l’anglais ? Probablement pas, car la TAN fonctionne mieux pour l’anglais, grâce à la richesse des corpus en ligne. En revanche, les IA pourraient favoriser un certain multilinguisme dans le même temps.

D’autres impacts possibles des IA de la traduction dans la production scientifique

Bien que les avancées des IA en matière de traduction aient été impressionnantes depuis le milieu des années 2010 et depuis la sortie de ChatGPT à l’automne 2022, il est clair que l’utilisation des IA reste en pleine évolution, y compris pour soutenir le multilinguisme dans la recherche. Des requêtes ChatGPT 4o et DeepSeek effectuées à la mi-février 2025, suggèrent une gamme assez importante de conséquences possibles, au-delà de ce qui ressort du sondage ci-dessus. L’encadré donne un aperçu de la requête auprès de DeepSeek.

Épistémologie de l’IA : quelles influences des IA de traduction dans la production scientifique ?

DeepSeek (12 février 2025) : L'épistémologie de l'intelligence artificielle (IA) explore les fondements, les méthodes et les implications de la connaissance produite par les systèmes d'IA. Dans le contexte des IA de traduction, leur influence sur la production scientifique est multidimensionnelle et soulève des questions à la fois pratiques et philosophiques.

Voici quelques aspects clés de cette influence :

- Accès et diffusion des connaissances

- Traduction automatisée : Les IA de traduction, comme Google Translate ou DeepL, facilitent l'accès à des articles scientifiques rédigés dans des langues étrangères […].

- Démocratisation de la science : En rendant les publications scientifiques accessibles à un public plus large, ces outils contribuent à réduire les barrières linguistiques et à favoriser une collaboration internationale plus inclusive.

- Qualité et fiabilité des traductions

- Limites des traductions automatisées : Bien que les IA de traduction aient fait des progrès significatifs, elles ne sont pas encore parfaites […].

- Responsabilité épistémique : Les chercheurs doivent rester critiques vis-à-vis des traductions automatisées et vérifier les informations clés […].

- Influence sur les pratiques de recherche

- Efficacité accrue : Les IA de traduction permettent aux chercheurs de parcourir rapidement une grande quantité de littérature scientifique dans différentes langues […].

- Dépendance technologique : Une dépendance excessive à l'égard des outils de traduction automatisée pourrait potentiellement diminuer les compétences linguistiques des chercheurs […].

- Impact sur la diversité linguistique

- Hégémonie de l'anglais : Les IA de traduction pourraient renforcer la domination de l'anglais comme lingua franca de la science […].

- Préservation des langues minoritaires : D'un autre côté, les IA de traduction pourraient aussi contribuer à préserver et à valoriser les langues minoritaires […]

- Questions éthiques et épistémologiques

- Biais culturels et linguistiques : Les IA de traduction peuvent reproduire et amplifier les biais présents dans les données sur lesquelles elles sont entraînées […].

- Authenticité et originalité : L'utilisation de l'IA pour traduire des travaux scientifiques soulève des questions sur l'authenticité et l'originalité des idées, surtout si les nuances et les contextes culturels spécifiques sont perdus dans la traduction.

- Collaboration interdisciplinaire

- Facilitation de la collaboration : Les IA de traduction peuvent faciliter la collaboration entre chercheurs de différentes disciplines et de différents pays […].

- Intégration des savoirs locaux : Elles peuvent également aider à intégrer des savoirs locaux et traditionnels dans le discours scientifique global […].

La même requête (prompt) auprès de ChatGPT 4o a aussi souligné notamment les possibilités d’une « standardisation et uniformisation des discours scientifiques », dans la mesure où les IA de traduction « contribuent à l’uniformisation des expressions et des tournures linguistiques » et que le recours à « un anglais globalisé […] pourrait influer sur la manière dont certaines notions scientifiques sont formulées et comprises ».

Les IA de la traduction offrent d’importantes possibilités à la recherche. Actuellement, elles semblent surtout faciliter la diffusion de la recherche en anglais, renforçant ainsi le statut de l’anglais comme lingua franca. Pour le moment, le travail de « post-édition » de la traduction automatique est toujours significatif, même si on constate déjà un certain glissement vers un « globish académique » – un anglais simplifié et appauvri – dans la publication scientifique. Il reste à voir si les IA de la traduction vont plutôt encourager des enrichissements interculturels ou favoriser une certaine uniformisation de la recherche mondiale. Plus généralement, se pose la question de l’articulation entre le savoir et les compétences acquises et maîtrisées par l’humain, ainsi que sa propre imagination et l’apport des IA.

Notes de bas de page

1 ROBERT A.-M., « La post-édition : l’avenir incontournable du traducteur ? », Traduire – Revue française de la traduction, 222 | 2010, [http://DOI : 10.4000/traduire.460].

2THROSSEL K., « La recherche ‘deepLisée’ ou pourquoi il faut se méfier de la traduction automatique », 4 septembre 2023, AOC Media, [https://aoc.media/opinion/2023/09/03/la-recherche-deeplisee-ou-pourquoi…;

3SMOKOTIN V., ALEKSEYENKON A.S. et PETROVAC G.I., « The Phenomenon of Linguistic Globalization: English as the Global Lingua Franca (EGLF) », Procedia - Social and Behavioral Sciences 154, 2014, p. 509-513, [https://doi.org/10.1016/j.sbspro.2014.10.177].

4NERRIERE J.-P. « Pour être global, parlons globish ! », L’Expansion Management Review, 2006/3 N°122, p 44-51, [https://shs.cairn.info/revue-l-expansion-management-review-2006-3-page-…].

5ROWLEY-JOLIVET E., « English as a Lingua Franca in research articles: the SciELF corpus », ASp [Online], 71 | 2017, Online since 01 March 2018, connection on 22 November 2024, [https://doi.org/10.4000/asp.4987].